在2023年,我参加了一次机器学习会议。当时夜色初暗,觥筹交错间,话题转向了一个有趣的问题:“如果你可以将某个机器学习子领域的所有资源转移给另一个领域,你会砍掉哪个,提升哪个?”

我已经不记得他们要提升哪个领域了,但有人说他们会砍掉机器人领域。当我进一步追问时,他们说机器人领域的进展太慢,相对于其他领域几乎没有什么变化。

我认为他们的观点是对的,机器人领域的进展确实比纯软件的机器学习子领域要慢。但我还想补充两点:

- 首先,机器人学习进展缓慢的原因是,任何进展都必须面对一些非常困难的问题。

- 其次,这些困难问题不仅仅局限于机器人领域。

在机器人领域中,一个非常常见的说法是“现实是混乱的”。我会进一步扩展为现实相对于代码来说是复杂的,在机器人领域,你经常需要将混乱的现实抽象成足够整洁的形式,以便代码能够作用于它。计算机科学领域已经花了几十年时间在硬件和软件之间创建良好的抽象层。代码描述了如何驱动电流到我的硬盘、处理器和显示器,足够可靠,以至于我甚至不用去考虑它。

这样做有很多好处!一旦你完成了这项艰苦的工作,并将进展转移到在抽象的逻辑空间中行动,一切都变得更容易。代码和数据是极其可复制的。我在三个设备上同步了这篇博客文章的草稿文件,根本不需要考虑它。

然而,正如Joel Spolsky所说,所有抽象都在某种程度上是有缺陷的,我发现这些缺陷在机器人领域更为明显。许多问题的出现与代码的正确性无关。

这是否因为这个学科本身存在某些根本性的问题?有一点。很多机器人硬件比笔记本电脑或Linux服务器更具实验性。消费类机器人行业还没有那么大。“实验性”往往意味着“奇怪,更容易达到失败状态”。

但我不认为硬件是主要的摩擦来源。现实才是摩擦。Benjamin Holson在他的“神话中的非机器人学家”一文中很好地总结了这一点:

“第一个难点是机器人处理的是现实世界,感知不完美,执行也不完美。全局可变状态是糟糕的编程风格,因为它真的很难处理,但对于机器人软件来说,整个物理世界就是全局可变状态,你只能不可靠地观察它,并希望你的行动能接近你想要实现的目标。”

机器人研究依赖于在现实和软件之间建立新的桥梁,但这在其他领域也是如此。任何与现实交互的软件都会对那种现实有不完美的了解。任何试图影响现实世界变化的软件都必须处理现实的全局可变状态。任何依赖现实中发生的事情的软件行为都会引入对抗性的噪音和复杂性来源。

游戏AI是一个有益的例子。国际象棋AI可靠地超越了人类。然而,一些超人的围棋AI如果你以特定方式下棋是可以被击败的,正如Wang和Gleave等人在2023年的ICML中所发现的。对抗性技术发现了一种策略,人类可以复现。

在附录G.2中,我们的一位作者,一位围棋专家,能够从对手的游戏记录中学习,并在没有任何算法辅助的情况下实施这种[循环]攻击。在在线围棋服务器KGS上,他们在标准的人类条件下对一个未与作者关联的顶级KataGo机器人获得了超过90%的胜率。即使给机器人让9个子,这个作者仍然赢了。9个子的让子是一个巨大的优势:一个职业棋手在这种让子下对任何对手,无论是人类还是AI,都会有几乎100%的胜率。他们还击败了KataGo和Leela Zero,后者每次使用10万次访问,远远超过人类的能力。其他人类后来也使用循环攻击击败了各种顶级围棋AI。

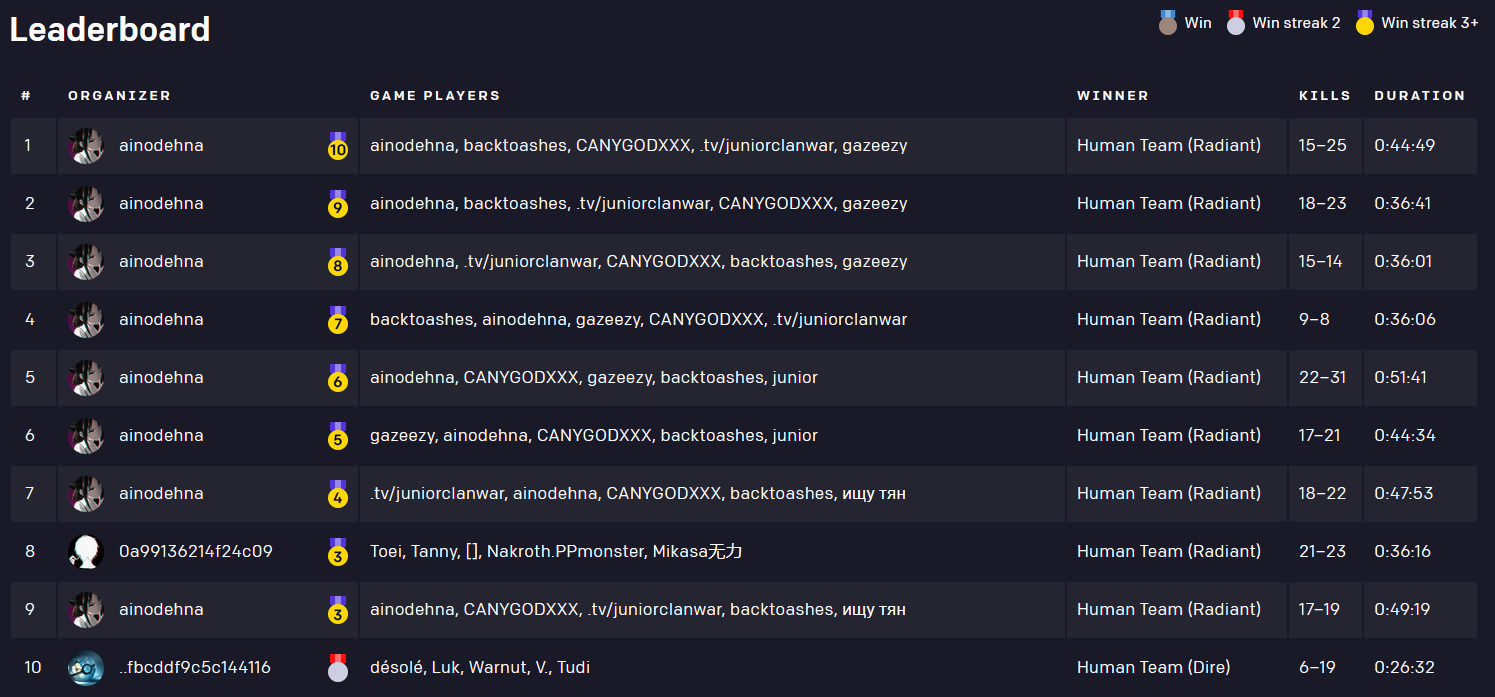

与此同时,几年前,OpenAI创建了一个系统,击败了当时的Dota 2世界冠军。在将系统开放给公众测试其鲁棒性之后,一个团队设计了一种策略,取得了10场连胜。

基于此,你可能持有一种悲观的观点,即连接一个简单的19×19围棋棋盘或Dota 2的“现实”足以增加复杂性,使鲁棒行为变得具有挑战性。我认为这种观点是不公平的,因为这些系统都没有将鲁棒性作为顶级目标,但我认为它们是一个有趣的案例研究。

最近,围绕大型语言模型(LLM)掀起了一波热潮——它们能做什么,能应用在哪里。所有这些背后隐含着一种信念,即LLM可以显著改变人们与技术的交互方式,无论是在工作中还是在娱乐中。换句话说,LLM将改变我们与现实的调解方式。我实际上也参与了这波热潮,具体来说,我怀疑基础模型在短期内被过度炒作,但从长远来看却被低估了。然而,这意味着所有现实的复杂性正在袭向一个历史上在考虑现实方面表现不佳的领域。在同一个ML会议上,当有人说机器人领域是在浪费资源时,我提到我们正在真实机器人中实验基础模型。有人告诉我这看起来有点可怕,我向他们保证这只是一个研究原型。但我也觉得LLM生成和执行软件有点可怕,我认为有趣的是他们隐含地担心一个但不担心另一个。硅谷类型的人有点矛盾。他们既相信软件可以推动惊人的变革型创业公司,又认为他们的软件不值得反思或内省。我认为比特世界与原子世界一样,都是现实的一部分。它们在不同的层次上运行,但仍然是现实的一部分。

我注意到(有些幸灾乐祸)LLM从业者不断发现机器人学早已遇到的痛点。“我们无法重现这些训练运行,因为它太资本密集了。”是的,这至少在机器人学领域已经讨论了十多年。“我无法让必应欺骗我关于《阿凡达2》上映日期的消息,因为它不断拉出自己写的新闻文章,并在生成前自我修正。”我们现在生活在一个任何公开可用的互联网文本都可以不可逆地影响增强检索生成的世界。欢迎来到全球可变状态。每当我看到有人声称ChatGPT的行为有回归现象时,我都会想起我和其他人为解释机器人性能的突然、无法解释的下降而提出的阴谋论,以及问题是模型、环境还是我们从有限数据中推断得太多。

有一句话说“所有机器人演示都是谎言”,人们发现所有LLM演示也是谎言。我认为这是不可避免的,因为人类注意力的限制。重要的是评估谎言的类型、大小和重要性。他们是否展示了它可以如何推广?他们是否提到例子是如何精心挑选的?一旦你将现实纳入其中,这些问题变得更加复杂。确实,梅西迄今看起来像一个好球员,但“他能在寒冷的雨夜在斯托克踢球吗?”

复杂的是,这些问题的答案并不总是“否”。梅西可以在寒冷的雨夜在斯托克踢球。他足够优秀。而这使得事情变得困难,因为在“是”上正确比在“否”上正确重要得多。随着LLM变得更好,随着AI在日常生活中变得越来越普遍——我们作为一个社会,将需要越来越善于决定模型是否已经证明了自己。我对未来的主要担忧之一是我们变得不善于评估模型是否已经证明了自己。但我预计机器人学家会走在前面。我们在声称LLM影响常见基准测试之前几年就在抱怨评估问题。我们试图获得足够的数据来捕捉自动驾驶的长尾现象,远在“我们需要更好的数据覆盖”成为基础模型预训练团队的口号之前。机器学习一直生活在一个泡沫中,机器人学家、化学家、生物学家和神经科学家都羡慕它,而当它开始真正起作用时,我们都会遇到其他领域多年面对的现实问题。这些挑战是可以克服的,但会很难。欢迎来到真实的世界。欢迎来到痛苦。

在线咨询

请输入您的问题:

提示:系统优先提供真人服务。非工作时间或繁忙时,会由 AI 生成回答,可能存在错误,请注意甄别。